Die Gleichung des Vertrauens: Chancen und Risiken künstlicher Intelligenz

Stellen Sie sich eine Welt vor, in der Ihr selbstfahrendes Auto Sie sicher durch die belebtesten Straßen fährt, in der jeder Fußgänger bemerkt und jedes Verkehrssignal beachtet wird, egal bei welchem Wetter oder zu welcher Tageszeit. Oder denken Sie an ein KI-gestütztes Recruiting-System, das die besten Kandidaten ausschließlich auf der Grundlage ihrer Fähigkeiten und ihres Potenzials identifiziert, völlig unabhängig von ihrem Geschlecht, ihrer Ethnie oder ihrer Herkunft. Das ist das Versprechen der künstlichen Intelligenz – eine Technologie, die unser Leben auf eine Weise verändern kann, die wir uns aktuell kaum vorstellen können.

Doch wie bei jedem mächtigen Werkzeug bringt KI auch eigene Herausforderungen mit sich. Nehmen Sie zum Beispiel ein KI-System im Gesundheitswesen, das Patienten aufgrund von voreingenommenen Trainingsdaten falsch diagnostiziert, was zu falschen Behandlungen und negativen Gesundheitsergebnissen führt. Oder betrachten Sie einen KI-gesteuerten Finanzalgorithmus, der bestimmte demografische Gruppen diskriminiert, was zu einer ungerechten Ablehnung von Krediten und Finanzdienstleistungen führt. Diese Geschichten unterstreichen die dringende Notwendigkeit einer robusten Regulierung, um sicherzustellen, dass KI-Systeme fair und verantwortungsvoll funktionieren.

Eine von Workday in Auftrag gegebene und von FT Longitude im November und Dezember 2023 durchgeführte Umfrage zeigte eine erhebliche Vertrauenslücke in Bezug auf KI am Arbeitsplatz. Die Umfrage wurde mit 1375 Führungskräften und 4000 Mitarbeiterinnen und Mitarbeitern aus 14 Ländern durchgeführt. Davon vertrauen nur 62% der Führungskräfte und 52% der Mitarbeiterinnen und Mitarbeiter der KI-Einführung in ihren Organisationen. Zu den wichtigsten Bedenken gehören das Fehlen klarer Richtlinien für den Einsatz von KI, unzureichende Fähigkeiten für die Umsetzung und die Unsicherheit über die ethische Bereitstellung von KI-Technologien.1

Um diese Probleme anzugehen, ist das Konzept der „vertrauenswürdigen KI“ entstanden, das ethische, faire, transparente und verantwortliche KI-Entwicklung betont. Vertrauenswürdige KI zielt darauf ab, die potenziellen Risiken von KI zu mindern und ihr volles Potenzial für eine nachhaltige Entwicklung zu erschließen. In Zukunft kann KI helfen, globale Herausforderungen wie den Klimawandel und die Ressourcenknappheit zu bewältigen, aber nur, wenn sie vertrauenswürdig und nach verantwortungsvollen Praktiken entwickelt wird.

Wie kann Vertrauen in KI gefördert werden?

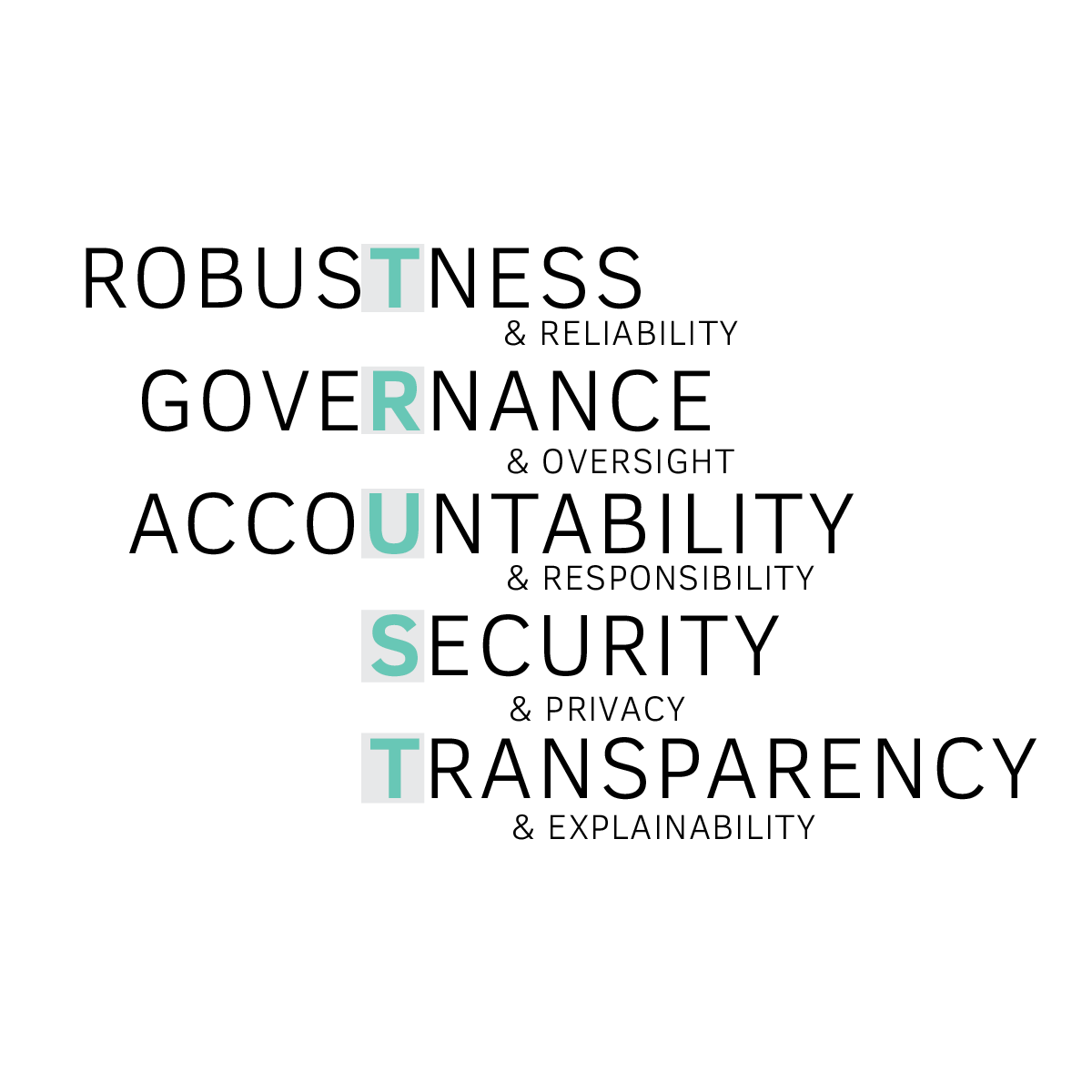

Um die Einhaltung dieser verantwortungsvollen Praktiken zu gewährleisten, wurden fünf Schlüsseldimensionen identifiziert, die garantiert werden müssen, um eine vertrauenswürdige KI-Lösung zu entwickeln und bereitzustellen.

- Robustness & Reliability: KI-Systeme müssen unter verschiedenen Bedingungen korrekt funktionieren und konsistente und verlässliche Ergebnisse liefern.

- Governance & Oversight: Ein Governance-Framework muss eingerichtet werden, um die ethischen Aspekte bei der Entwicklung und Implementierung von KI-Systemen zu überwachen.

- Accountability & Responsibility : Durch die Definition klarer Rollen und Verantwortlichkeiten für alle Stakeholder, die an KI-Systemen beteiligt sind, kann die Verantwortung für die Ergebnisse sichergestellt werden.

- Security & Privacy: Daten, die von KI-Systemen verwendet werden, müssen bereinigt werden, um die Privatsphäre der Einzelnen zu schützen und die Fairness und Sicherheit sensibler Informationen zu gewährleisten.

- Transparency & Explainability: KI-Systeme müssen so entwickelt werden, dass sie klare, verständliche und nachvollziehbare Entscheidungen liefern, um Vertrauen zu ermöglichen.

Auch die EU fördert das Vertrauen in KI, indem sie einen präzisen regulatorischen Rahmen bereitstellt: den EU AI Act

Die Europäische Union hat mit der wegweisenden EU-Verordnung (EU AI Act) eine führende Rolle in der KI-Regulierung übernommen. Diese Gesetzgebung zielt darauf ab, einen Rahmen für die Entwicklung, Bereitstellung und Nutzung von KI-Systemen zu schaffen, in dem Vertrauen, Sicherheit und ethische Prinzipien priorisiert werden. Im EU AI Act wird ein risikobasierter Ansatz verfolgt, wodurch KI-Systeme in vier Kategorien gegliedert werden:

Minimales Risiko

Für einfache Spiele oder Datenfilter gelten nur minimale regulatorische Anforderungen, da sie für Benutzer oder die Gesellschaft kaum oder gar kein Risiko darstellen.

Begrenztes Risiko

Systeme wie Chatbots und Spamfilter erfordern eine gewisse Nachverfolgbarkeit, unterliegen aber weniger strenger Kontrolle.

Sie müssen ein gewisses Maß an Transparenz aufweisen, indem über die Nutzung von KI in dem jeweiligen System informiert wird. Zusätzlich dazu ist ein geringes Maß an Risikomanagement notwendig.

Hohes Risiko

KI-Systeme in kritischen Bereichen wie Infrastruktur oder bei CV-Screenings müssen vor der Markteinführung strenge Anforderungen erfüllen.

Zu diesen Anforderungen gehören strenge Tests, Dokumentations- anforderungen und Transparenz, um sicherzustellen, dass die Nutzung der KI nicht zu erheblichen Risiken für Gesundheit, Sicherheit oder sogar zur Verletzung der Grundrechte führt.

Inakzeptables Risiko

KI-Systeme, die eine klare Bedrohung für Grundrechte, Sicherheit oder Ordnung darstellen, sind verboten. Beispiele hierfür sind von Regierungen verwendete Social-Scoring-Systeme und biometrische Identifikationssysteme.

Diese Systeme erfüllen nicht die Anforderung, keine grundlegenden Menschenrechte zu verletzen oder keine erhebliche Sicherheitsbedrohung darzustellen

Der EU AI Act markiert nur den Anfang der Reise hin zu einer verantwortungsvollen Nutzung und Bereitstellung von KI. Obwohl der EU AI Act sicherlich als Katalysator für einen positiven Wandel dient, indem ein Standard für ethische KI-Praktiken durch Förderung von Transparenz, Verantwortung und Fairness gesetzt wird, brauchen Unternehmen mehr als nur Regulierungen, um vertrauenswürdige KI zu ermöglichen.

Um eine wirksame Governance und Compliance von KI-Systemen zu gewährleisten, muss ein umfassender Ansatz gewählt und innerhalb des gesamten Unternehmens umgesetzt werden.

- Zunächst müssen alle KI-Systeme und die wichtigsten Stakeholder, die für diese Systeme verantwortlich sind, identifiziert werden.

- Anschließend muss ein KI-Systemkatalog erstellt werden, der jedes KI-System nach seinem Risikograd klassifiziert.

- Auf der Grundlage dieser Risikoklassifizierung werden geeignete Maßnahmen abgeleitet und eine Compliance-Strategie entwickelt, um diese Maßnahmen in der gesamten Organisation umzusetzen.

- Die Governance-Strukturen sind zu überprüfen und anzupassen, um klare Rollen und Verantwortlichkeiten zuzuweisen, die sicherstellen, dass die Organisation richtig strukturiert ist, um eine kontinuierliche Überwachung sowohl bestehender als auch neuer KI-Systeme zu gewährleisten.

- Personen, die mit KI-Systemverantwortlichkeiten betraut sind, müssen geschult werden, um ihre Fähigkeiten und ihr Verständnis für eine vertrauensvolle KI zu stärken und eine effektive Überwachung der KI-Systeme zu ermöglichen.

- Zusätzlich müssen Sensibilisierungsmaßnahmen durchgeführt werden, um alle Mitarbeiterinnen und Mitarbeiter über die Bedeutung und die Auswirkungen von KI-Systemen in der Organisation aufzuklären.

Dieser ganzheitliche Ansatz schafft einen robusten Rahmen für das Management von KI-Systemen, wodurch Compliance sichergestellt wird und so die Risiken effektiv minimiert werden.

Füllen Sie das untenstehende Formular aus und erhalten Sie jetzt Zugang zu den wichtigsten Fakten über den EU AI Act

Der Weg zu einer verantwortungsvollen KI gestaltet sich nicht einfach, doch durch frühzeitiges Handeln kann der Grundstein für eine vertrauenswürdigere Zukunft gelegt werden

Der EU AI Act markiert eine neue Ära der KI-Regulierung und positioniert Europa als globalen Vorreiter in der Förderung vertrauenswürdiger KI. Das umfassende Rahmenwerk der Verordnung stellt einheitliche Regeln für die KI-Entwicklung, Vermarktung und Nutzung in der gesamten EU sicher, wobei Sicherheit und Grundrechte oberste Priorität haben. Unternehmen sind für jeden durch KI-Systeme verursachten Schaden haftbar und es drohen Strafen von bis zu 35 Millionen Euro oder 7% des Umsatzes. Die Einhaltung dieser Vorschriften ist nicht nur eine rechtliche Verpflichtung, sondern auch eine strategische Notwendigkeit, um durch vertrauenswürdige Innovation Wettbewerbsvorteile erzielen zu können.

Die Befolgung der in der Verordnung skizzierten Prinzipien kann Organisationen dabei helfen, ihre Wettbewerbsposition zu stärken und das Vertrauen von Kunden und Partnern zu gewinnen. Da die KI-Verordnung Ende Mai 2024 formal verabschiedet wurde, ist eine proaktive Anpassung an diese Regulierungen entscheidend, um die Grundlage für eine Zukunft zu schaffen, in der verantwortungsvolle KI Innovation vorantreibt.

1 Workday Global Survey Reveals AI Trust Gap in the Workplace – Jan 10, 2024

ISO/IEC 27001:2013 zertifiziert

ISO/IEC 27001:2013 zertifiziert